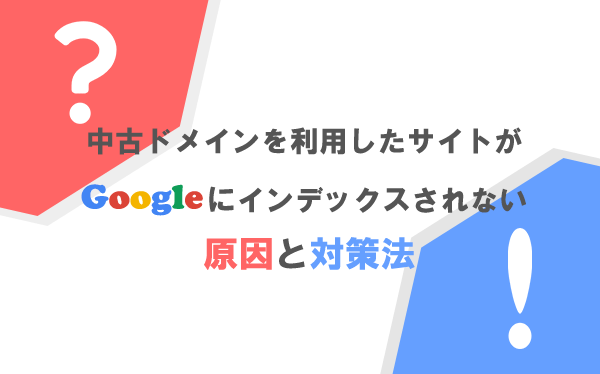

中古ドメインを利用したサイトがGoogleにインデックスされない原因と対策法

投稿日:2019/09/02 (更新日:)

- 取得した中古ドメインがGoogleにインデックスされない原因はペナルティ

- その他にサイトがインデックスされない原因と対策方法

- Googleにインデックスされやすくするためにサーチコンソールを利用すること

中古ドメインや新規ドメインを利用してサイト運用していると、サイトのページがGoogleのクローラー(検索エンジン)にインデックスされないことがあります。

Googleのクローラーに運用しているサイトのページがインデックスされないと、Googleの検索結果に表示されずに自然(オーガニック)検索でページ内に流入させることができません。

サイトのページがインデックスされない原因はいくつか考えられますが、中古ドメイン自体による原因でサイトのページがGoogleにインデックスされないことがあります。

今回は、中古ドメインでサイト運用していてページがGoogleにインデックスされない原因と対策方法、その他にサイトのページがインデックスされない原因と対策方法について解説をしていきます。

取得した中古ドメインがGoogleにインデックスされない原因はペナルティ

取得した中古ドメインでサイト運用を始めたとき、Googleにページがインデックスされない原因はペナルティが考えられます。

そもそもペナルティは、Googleが定めている「品質に関するガイドライン」に違反している・準拠していないサイトに対して、Googleが行う処置のことです。

サイト、正確にはドメインがペナルティを受けてしまうと、Googleのクローラーから検索順位を下げられたりインデックスの削除をされる、など検索結果の上位に表示することができなくなります。

このペナルティを受けている中古ドメインを取得して、いざサイト運用を始めようとしても、Googleにページをインデックスさせることができないでしょう。

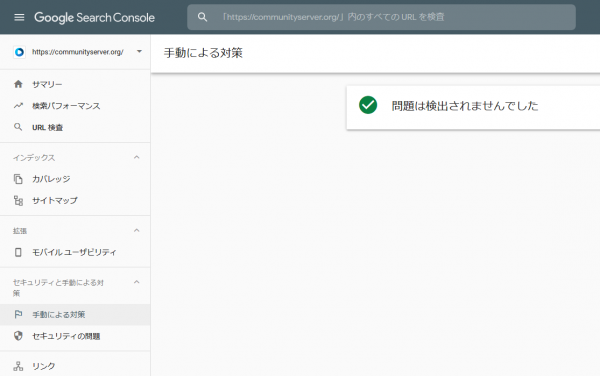

取得した中古ドメインがペナルティを受けているか確認するには、Googoleが提供しているツールの「サーチコンソール」を利用します。

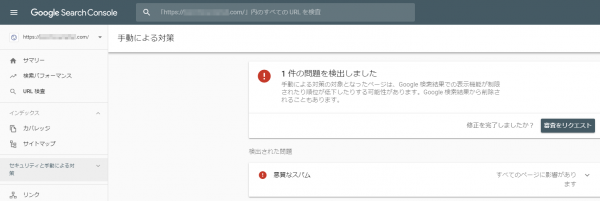

サーチコンソールに取得したドメインの登録(プロパティの追加)をして、左のメニューにある「セキュリティと手動に対する対策」→「手動による対策」の画面に移動すると、ドメインがペナルティ(手動ペナルティ)を受けているか確認をすることができます。

取得した中古ドメインに手動ペナルティを受けていなければサーチコンソールの「手動による対策」画面に「問題は検出されませんでした」と表示されます。

一方、ドメインに手動ペナルティを受けていると「手動による対策」画面にエラーが表示されます。

ペナルティを受けていたら解除するか手放すかのどちらか

サーチコンソールから取得した中古ドメインにペナルティを受けていたと判明した場合、サイトのページをインデックスさせるには、ペナルティの解除を行うかドメイン(中古ドメイン)を手放すかのどちらかです。

ペナルティの解除には、まずペナルティの原因を突き止める必要があります。

ペナルティの原因を突き止めるには、サーチコンソールの「セキュリティと手動に対する対策」→「手動による対策」の画面にいきます。

「手動による対策」の画面にある項目「検出された問題」の部分を選択すると、ペナルティを受けた原因が記述されているはずです。

ペナルティの原因を突き止めて対策を行ったら、ペナルティの解除申請をサーチコンソールからGoogleに申請します。

一方、取得した中古ドメインの価格にもよりますが、費用対効果を考えるとドメインを手放して新たに中古ドメインを取得したほうがよいケースがあります。

サイト公開が遅れても支障ないようであればペナルティの解除を行うといいでしょう。

ペナルティを解除するのか、ドメインを手放すのか、どちらがベストな選択なのかは人それぞれなのでよく考えましょう。

初心者がペナルティを受けている中古ドメインを避けるのは難しい

そもそも中古ドメインを取得するときには、ペナルティを受けていないものを選ぶことが大事です。

中古ドメインは個人で探すことができますが、経験に基づく目利きがないとペナルティを受けている中古ドメインに当たってしまう可能性があります。

なので、中古ドメインの初心者が個人で中古ドメインを探すのはオススメできません。

時間効率を考えると、アクセス中古ドメインのような中古ドメイン販売を行う業者から購入するといいでしょう。

因みに、当店のアクセス中古ドメインで取り扱っている中古ドメインは品質重視で、ペナルティを受けていないものだけを取り扱っています。

その他にサイトがインデックスされない原因と対策方法

サイトのページがインデックスされない原因はペナルティの他にも存在します。

もし、取得した中古ドメインにペナルティを受けていなければ、別の原因が考えられます。

サイトのページがインデックスされない原因は主に7つ挙げられます。

- クローラーが巡回しにくいリンク構造になっている

- meta robotsタグでnoindexを指定している

- robot.txt側の設定でクロール拒否をしている

- canonicalタグの記述ミスをしている

- .htaccessファイルにX-robots-tagを記述している

- サイトのページが500エラーを起こしている

- 新規ドメインでサイト運用をしている

クローラーが辿りにくいリンク構造になっている

クローラーにとってサイト内がたどりにくいリンク構造になっている場合、Googleにページがインデックスされない可能性があります。

そもそも、クローラーはサイト内のページにあるリンクをたどって、クロール(各ページの情報を収集する)した情報をGoogleのデータベースに保存され、インデックスされます。

このクローラーが何らかの理由でリンクをたどれない、クロールしにくいリンク構造だとインデックスされないことがあります。

インデックスされにくい、たどりにくいリンク構造を例に挙げると以下になります。

- リンク階層が深すぎる(サイト内の階層構造に従ってリンクを辿るため)

- 低品質コンテンツのページ(インデックスする価値がない)

- どのページからもリンクが設置していない・されていない(孤立した状態)

クローラーがスムーズにリンクをたどりやすくする、つまりクローラビリティを改善する必要があります。

クローラビリティの改善には、内部リンクの見直しが必要です。

例えば、内容が似ているコンテンツをカテゴリーとして1つにまとめて、ディレクトリ構造を整えます。

ディレクトリ構造を整えることで、カテゴリーとしてのテーマ性が高まり、クローラビリティの向上だけでなくユーザーにとっても使いやすいサイトになります。

以上から、内部リンクを見直してクローラーにリンクを辿りやすくするために、クローラビリティの改善を行いましょう。

meta robotsタグでnoindexを指定している

HTMLファイルのmeta robotsタグ内にnoindexを指定すると、クローラーはインデックスしないページと判断します。

meta robotsタグにnoindexを指定したページは、Googleにインデックスされません。

meta robotsタグにnoindexを指定した記述例は以下の通りです。

<meta name="robots" content="noindex">

※不等号(<>)は全角になっているので、半角に直してください。

meta robotsタグは、headタグ内に記述しています。

インデックスさせたいページにnoindexが記述していないか確認を行い、もしnoindexがページに記述していれば解除を行いましょう。

Wordpressでサイト運用をしている場合、noindexの解除はWordPressの管理画面から「設定」→「表示設定」にある「検索エンジンがサイトをインデックスしないようにする」にチェックが入っていないか確認をしましょう。

また、プラグインの「All in One SEO Pack」を利用している場合、それぞれの固定ページ・投稿ページにnoindexを設定していないか確認をしましょう。

その後、noindexの解除をGoogleのクローラーに知らせるために、サーチコンソールの「URL検査ツール」という機能を利用して、クローラーにページをクロールしてもらえるようにリクエストをしましょう。

robot.txt側の設定でクロール拒否をしている

robot.txtファイルの中に、検索エンジンのクロールを拒否する内容が記述されていると、Googleにページがインデックスされません。

robot.txtファイルでクロール拒否をしている記述例は以下の通りです。

User-Agent:* Disallow: /sample/

上記、記述例のように「Disallow」で指定された対象ページや対象ディレクトリは、「User-Agent」で指定されたクローラーにクロールされずに、Googleにインデックスされないという仕組みです。

User-Agentで指定している「*」はワイルドカードといい、全てのクローラーを対象にしています。

User-Agentの指定部分を「Googlebot」にすると、Googleのみクロール拒否ができます。

robot.txtファイルの中に、クロール拒否をする内容が記述されていないか確認をしましょう。

もしもクロール拒否をする内容が記述されていたら、その部分を削除してrobot.txtを再度アップロードしましょう。

robot.txtファイルは、FTPソフトを利用すればアップロードができます。

robot.txtファイルを再度アップロードすると、Googleのクローラーがサイト内に訪れたときにrobot.txtファイルをみます。

robot.txtファイルにクロール拒否をする内容が記述されていなければ、サイトのページがインデックスされるでしょう。

アップロード先を間違えると、ファイルを認識されなくなってしまうので注意しましょう。

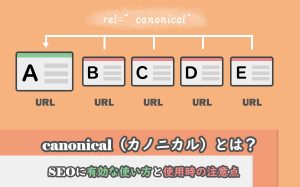

canonicalタグの記述ミスをしている

重複コンテンツの対策でURLの正規化である「canonical」タグを用いることがあります。

canonicalタグは、類似あるいは同一のページが2つ以上存在する場合、Googleはどのページをインデックスすればいいのか・評価をすればいいのかが分からず、重複コンテンツとして低評価を受ける可能性があります。

Googleに重複コンテンツとして評価されないためにも、canonicaタグで正規のページを示すことができます。

このcanonicaタグでインデックスさせたいページ(URL)と異なっている場合、本来の目的とは異なる別のページ(URL)がインデックスされる可能性があります。

同一のページでアクセスできる状態を例に挙げると、以下になります。

- http://example.com/

- http://www.example.com/

- http://example.com/index.html

上記、ページの中からインデックスさせたい、つまり評価させたいページを1つ決めて、canonicalタグを下記のように記述します。

今回は、「http://www.example.com/」と「http://example.com/index.html」のページに「http://example.com/」のページを指定して正規化を行っている例です。

WordPressでサイト運用をしている人は、プラグインの「All in one SEO Pack」を使えば、canonicalタグの設定を比較的、簡単に行えます。

ここで、canonicalタグを設定する前に1つ注意点があるのですが、canonicalタグは正規化すべきURLをGoogleのクローラーに伝えることができますが、強制力がないため評価させたいURLが必ずしもインデックスされるとは限りません。

なので、canonicalタグの設定だけでなく、

- WordPressの管理画面の一般設定にある「サイトアドレス (URL)」にインデックスさせたいURLを記述する

- .htaccessファイルを利用して正規化させたいURLを301リダイレクトで設定する

など、対策を合わせることで、評価させたいURLにインデックスさせることができるでしょう。

.htaccessファイルにX-robots-tagを記述している

リダイレクトや404エラーページの作成に用いられる.htaccessファイル内に「X-robots-tag」が記述されていると、Googleにサイトのページがインデックスされません。

X-robots-tagは、クローラーにPDFファイルや画像ファイルなど特定のファイルをインデックスさせないときに使われます。

ページをインデックスをさせなくするときに、metaタグの1つである<meta name="robots" content="noindex">が使われます。

しかし、PDFファイルや画像ファイルなどはmetaタグの設置ができなく、noindexの指定ができないので、その代わりとしてX-robots-tagを使うことでサイトのページをインデックス登録させないようにできます。

この、X-robots-tagを.htaccessファイル内に記述した例が以下になります。

Header set X-Robots-Tag "noindex"

上記に記述しているX-Robots-Tagの内容は、サイト内にある全てのPDFファイルを指定しています(PDFファイルはインデックスさせない状態)。

ページをインデックスさせたい場合は、.htaccessファイルやhttpd.confファイル、HTTPヘッダーなどにX-Robots-Tagが記述されていないか確認をして、記述されていたら削除をしましょう。

X-Robots-Tagの部分を削除すると、今までX-Robots-Tagで指定されていたページがインデックスされるようになるはずです。

サイトのページが500エラーを起こしている

サイトで500エラーを起こしているページは、Googleにインデックスされないことがあります。

500エラーとは、サーバー側で何らかの問題が起こったときに発生するステータスコードのことです。

ページが500エラーを起こす原因は、WordPressのプラグインの不具合やサーバーのディスク容量不足、.htaccessファイルの記述ミス、etc....などが考えられます。

ページが500エラーを起こしている状態でクローラーがページにやってきたとき、500エラーによってクローラーがページの情報を取集することができなく、結果的にインデックス登録ができません。

本来、500エラーは日常的に起こるので、短期的な500エラーだと再びクローラーがページにやってきてページの情報を収集してインデックス登録がされれば問題はないのですが、長期間の500エラーが続くようであればページのインデックス登録がされません。

まずは、エラーが発生しているか確認をするために、サーチコンソールの「カバレッジ」機能を利用してエラーを起こしているページの確認を行いましょう。

また、長時間のサイトメンテナンスが続くようであれば、ステータスコードの503エラーを返すことで、クローラーにサイトがメンテナンス中だと認識させることができます。

新規ドメインでサイト運用をしている

中古ドメインでサイト運用している方には該当しませんが、新規ドメインでサイト運用をしている場合、Googleにページがインデックスされないことがあります。

先ほど少し触れましたが、クローラーはリンクをたどってサイト内のページを見つけます。

リンクをたどってきたクローラーはそのページの情報(コンテンツ)を収集して、Googleのデータベースに保存され、インデックスされます。

新規ドメインでサイト運用を始めた頃はリンクの数が少ないため、クローラーがサイトを見つけられない、つまりインデックスされないケースがよくあります。

新規ドメインでサイトのページをインデックスさせるには、アクセス数を増やしましょう。

新規ドメインでサイト運用をしていき、サイト内のアクセス数が増えるとクローラーに見つけてもらいやすくなります。

サイトの運用方法によって異なるので一概にはいえませんが、新規ドメインでサイト運用してから数週間から数か月してからサイトのページがインデックスされます。

サイト内のアクセス数を増やすためには、SEO対策が欠かせません。

検索キーワードによってユーザーの疑問や知りたいことを理解して、その答えをコンテンツ内に盛り込むことがSEO対策で大事なことの1つです。

Googleにインデックスされやすくするためにサーチコンソールを利用すること

Googleにインデックスされない原因と対策法について解説をしてきました。

先ほど少し触れましたが、Googleのクローラーにサイトのページの存在を知ってもらうためには、サーチコンソールの「URL検査ツール」の機能を利用しましょう。

サーチコンソールのURL検査ツールを利用すると、Googleのクローラーにクロールまたは再クロールをさせるようにリクエストをすることができます。

旧バージョンのサーチコンソールでは、「Fetch as Google」という名前でGoogleのクローラーにクロールまたは再クロールをさせるようにリクエストをしていました。

いち早くGoogleのクローラーにページをクロールしてもらうためには、URL検査ツールの利用が不可欠です。